Mehr Rechenkraft für die Münchner KI-Forschung

02.03.2021

Technologie-Vorreiter: Das Munich Center for Machine Learning und das Leibniz-Rechenzentrum haben die auf KI ausgelegte Systemarchitektur optimiert.

02.03.2021

Technologie-Vorreiter: Das Munich Center for Machine Learning und das Leibniz-Rechenzentrum haben die auf KI ausgelegte Systemarchitektur optimiert.

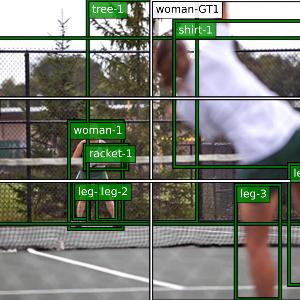

Bildverstehen ist ein Anwendungsfeld des Maschinellen Lernens. | © S. Sharifzadeh et al.: Proceedings of the AAAI Conference on AI (2021)

In den vergangenen Jahren hat sich Künstliche Intelligenz (KI) rasant weiterentwickelt, das Maschinelle Lernen ist eine ihrer Kerntechnologien. Rechnersysteme lernen dabei nicht mehr durch explizite Programmierung, sondern extrahieren selbst Wissen aus riesigen Datenmengen. Darauf werden sie mit einer Fülle von Beispielen trainiert. Den eigentlichen Durchbruch dabei brachten sogenannte Deep-Learning-Verfahren: Das System lernt funktionale Zusammenhänge mithilfe künstlicher neuronaler Netze. Und je komplexer die neuronalen Netze und je komplizierter die erlernte Funktion, desto größer der Bedarf an Rechenleistung.

Das Munich Center for Machine Learning (MCML) hat jetzt zusammen mit dem Leibniz-Rechenzentrum (LRZ) der Bayerischen Akademie der Wissenschaften eine State-of-the-Art-Rechnerinfrastruktur in Garching aufgebaut. „Die zusätzlich installierte Hardware repräsentiert den neuesten Stand der Technik und garantiert einen Standard, wie ihn nur die führenden KI-Zentren Deutschlands bieten können“, betont Professor Thomas Seidl, Inhaber des Lehrstuhls für Datenbanksysteme und Data Mining an der LMU. Er ist einer der drei Direktoren des MCML und gehört obendrein dem Direktorium des LRZ an.

Die auf den Bedarf der KI-Forschung ausgelegte Erweiterung der LRZ-Infrastruktur besteht aus 64 Graphics Processing Unit (GPUs). Jeweils acht dieser besonders leistungsfähigen speziellen Recheneinheiten sind zu einem Knoten zusammengefasst und eng miteinander vernetzt. Wiederum acht dieser sogenannten DGX-A100-Knoten von NVIDIA bilden den gesamten GPU-Cluster. „Das besonders leistungsfähige System hebt die KI-Forschung am MCML auf die nächste Stufe. Gepaart mit einem auf KI-Anwendung optimierten Hintergrundspeicher und einem äußerst performanten Netzwerk ermöglicht das Cluster neue Ansätze etwa bei Sprachverarbeitung und Bildanalyse zu erforschen“, sagt Nicolay J. Hammer, Leiter des Teams Big Data und Künstliche Intelligenz am LRZ. Das System trägt den Namen „MUNICH.ai (Mcml UNIversal Cluster for High-performance AI)".

GPUs gehören mittlerweile zu den gängigen Hardwareressourcen für das Deep Learning in Forschung und Anwendung. Solche Systeme machen es möglich, bis zu 40 Billiarden algebraische Operationen parallel auszuführen und komplexe Funktionen mit Millionen von Parametern weit schneller als zuvor zu trainieren. Im Wesentlichen steht hinter dem Deep Learning ein mathematischer Optimierungsprozess, das Lernen moduliert – nach dem Vorbild des Gehirns – die Verbindungen zwischen den in diesem Falle künstlichen Neuronen des Netzes.

Das Munich Center for Machine Learning (MCML) ist eine gemeinsame Initiative von LMU und Technischer Universität München und gehört zu den sechs Kompetenzzentren für KI-Forschung, die das Bundesministerium für Bildung und Forschung (BMBF) fördert. Auch den neuen GPU-Cluster am LRZ hat das BMBF mit gut zwei Millionen Euro gefördert. Das MCML versammelt derzeit 18 Teams aus den Fachgebieten Data Science, Informatik und Statistik sowie Anwendungsbereichen bis hin zu den Geisteswissenschaften. Ziel des Zentrums ist es, die Grundlagenforschung im Bereich des Maschinellen Lernens mit engem Bezug zu Anwendungen in der Praxis voranzutreiben.